مقدمة

إطلاق أي نظام ذكاء اصطناعي مؤسسي مثل agentic ai للمؤسسات يتطلب تحضيرًا شاملًا على مستوى الأمان، خاصة إذا كان هذا النظام مدمجًا مع البنية الرقمية الحساسة للمؤسسة. وقبل لحظة الـ Go-Live، ينبغي أن تتم مراجعة أمان متكاملة تتجاوز المفاهيم التقنية التقليدية إلى حوكمة الذكاء الاصطناعي، حماية البيانات، ورصد المخاطر الناتجة عن الأتمتة.

من خلال هذا الدليل، نستعرض قائمة مراجعة أمنية من 20 نقطة رئيسية يجب التأكد منها قبل نشر أي مشروع Agentic AI مؤسسي، ضمن إطار عمل Singleclic باستخدام منصة Cortex منخفضة الكود (تجربة عربية أولًا).

20 نقطة مراجعة أمنية قبل Go-Live

- تفعيل التحكم في الوصول (RBAC): تأكّد من تطبيق صلاحيات الدور Role-Based Access Control لضبط من يمكنه الوصول إلى قدرات Agentic AI.

- حماية البيانات الحساسة (PII): تشفير بيانات المستخدم الحساسة أثناء النقل والتخزين.

- إعداد سجل تدقيق مفصل: حفظ جميع الأنشطة في سجل Audit Log قابل للتصدير والمراجعة.

- مراجعة قواعد الإدخال والإخراج: منع إدخال بيانات أو استعلامات ضارة (Injection)، خاصة مع النماذج التوليدية.

- مقارنة بالـ OWASP Top 10: تأكّد من توافق النظام مع مخاطر تطبيقات LLM من OWASP.

- إجراء اختبار اختراق: تنفيذ Penetration Testing على الخدمات والواجهات المرتبطة بـ Agentic AI.

- عزل بيئة التطوير عن الإنتاج: استخدام بيئة staging لاختبار التحديثات قبل نشرها.

- تعطيل الميزات غير الضرورية: تقليل الهجوم المحتمل عبر إزالة المزايا غير المستخدمة.

- تشغيل أدوات DLP (منع تسريب البيانات): لمنع إرسال البيانات الحساسة عن طريق الخطأ إلى خارج النظام.

- التحقق من التوافق مع إطار NIST: مراجعة المخرجات وفق إطار NIST لإدارة مخاطر الذكاء الاصطناعي.

- استخدام سجل نسخ احتياطي تلقائي: ضمان استرجاع النظام بعد أي خلل محتمل.

- تحديد حدود التشغيل (Rate Limits): منع الاستخدام الزائد أو الهجمات المتكررة.

- تحقق من الأنشطة المشبوهة بالذكاء الاصطناعي: تحليل السلوك غير الطبيعي من المستخدمين أو الأنظمة.

- مراقبة الأداء الأمني باستمرار: دمج النظام مع أدوات SIEM لمتابعة التنبيهات.

- إشعار المستخدم عند حدوث تسريب: نظام إشعارات داخلي لتسريب البيانات أو فشل الأمان.

- تنفيذ نظام المراجعة البشرية: خاصة لنتائج النماذج الحساسة أو القرار الآلي المؤثر.

- الامتثال لمعيار ISO/IEC 42001: حوكمة الذكاء الاصطناعي هي محور ضمان الشفافية والثقة.

- تنفيذ قيود على الاستدعاء الخارجي للبيانات: تجنّب ربط النظام بمصادر خارجية غير موثوقة.

- تحديث النماذج والتعريفات دوريًا: سواء في قواعد الأمان أو التعلّم الآلي.

- تأكيد التوافق مع معمارية Singleclic: لضمان التكامل السلس عبر Agentic AI من سنجل كليك: الدليل الشامل لتسريع بناء تطبيقات الأعمال.

كيف تنفّذ المراجعة الأمنية فعليًا؟

- حدد فريق المراجعة: يشمل مهندسي الأمن، مطوري الأنظمة، وإداريي الأعمال.

- استخدم أدوات تدقيق آلي + يدوي: مثال: أدوات تحليل الأكواد، أنظمة مراقبة الـ API، وأنظمة SIEM.

- وثّق كل نقطة مراجعة: أنشئ تقريرًا لكل بند في القائمة أعلاه مع حالة “جاهز/غير جاهز”.

- نفّذ مراجعة ثانية بعد المعالجة: للتأكد من تنفيذ المعالجات قبل الإطلاق الرسمي.

- قدّم التقرير للإدارة العليا: كوثيقة رسمية تدعم قرار الذهاب إلى الإنتاج.

تفاصيل إضافية وأمثلة

- في مؤسسة مالية خليجية، ساعدناهم عبر منصة Cortex على تنفيذ Agentic AI لفحص العقود تلقائيًا. بعد فحص النقاط الأمنية، تم حظر أحد الـ APIs غير المؤمنة الذي كاد أن يعرّض آلاف العقود للتسريب.

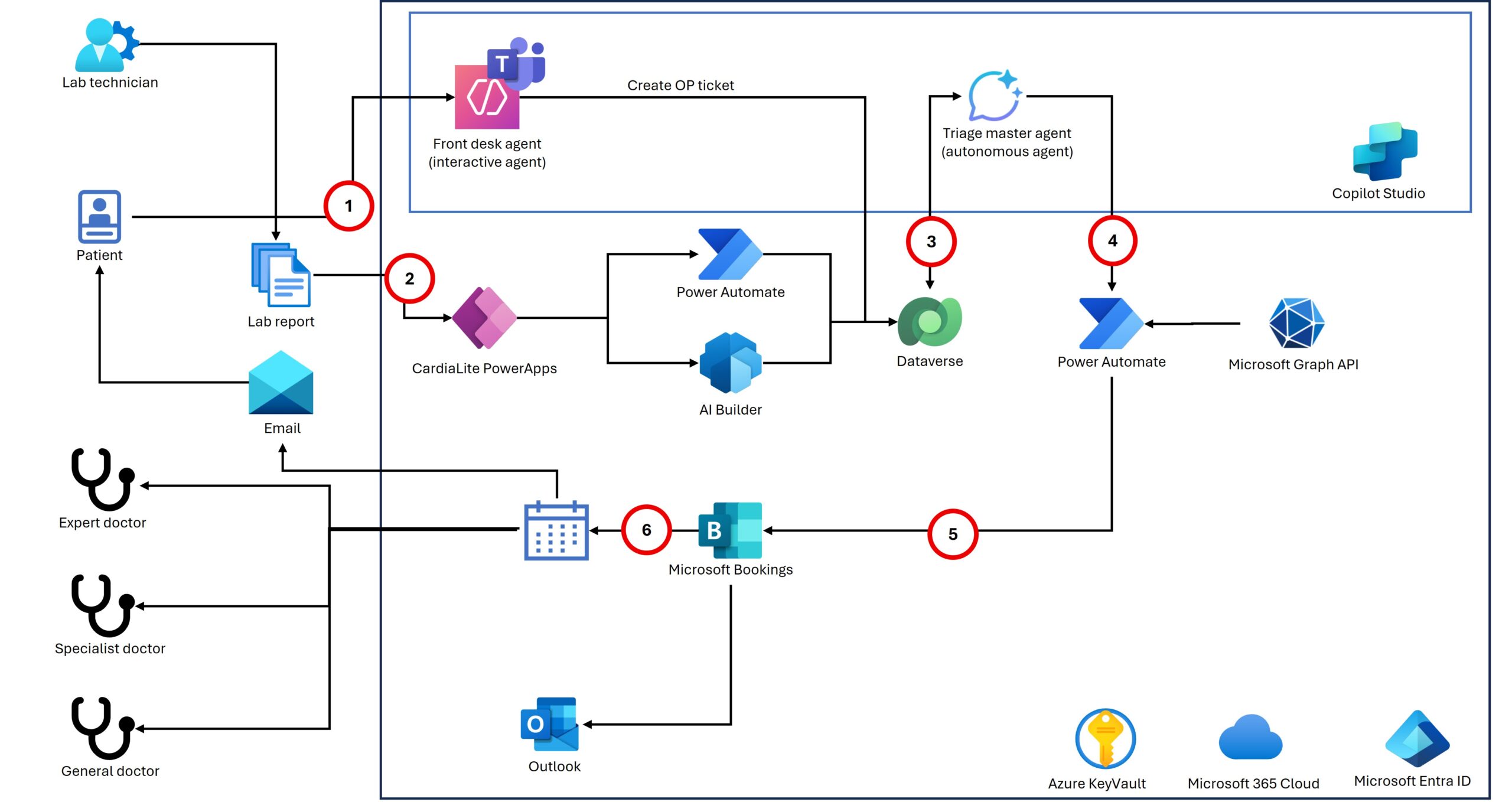

- في قطاع الرعاية الصحية، تم دمج النظام مع بوابة المرضى، مع تفعيل DLP تلقائي يحظر مشاركة بيانات الحساسية المرضية خارج المؤسسة.

اقرا المزيد

- Agentic AI من سنجل كليك: الدليل الشامل لتسريع بناء تطبيقات الأعمال

- منصّة Cortex منخفضة الكود (تجربة عربية أولًا)

- الدليل الشامل لـ Agentic AI من سنجل كليك

الأسئلة الشائعة (FAQ)

1. هل المراجعة الأمنية ضرورية دائمًا قبل نشر Agentic AI؟

نعم، لتجنّب التسريبات والأخطاء التلقائية التي قد تُحدث أضرارًا تشغيلية وقانونية.

2. ما الأدوات التي يمكن استخدامها للمراجعة؟

أدوات مثل ZAP أو Burp Suite، بالإضافة إلى أدوات SIEM مثل Splunk.

3. هل توجد أدوات جاهزة ضمن Singleclic للمراجعة؟

نعم، تقدم Singleclic وحدات تدقيق ومراقبة مدمجة ضمن منصة Cortex.

4. كيف أتعامل مع الخصوصية عند دمج Agentic AI مع الأنظمة الصحية أو المالية؟

تطبيق DLP، تشفير البيانات، وعزل الأدوار الحساسة.

5. ما الفرق بين اختبار الاختراق ومراجعة الأمان؟

الاختبار يحاكي الهجوم، أما المراجعة فهي تقييم شامل للثغرات قبل حدوث الهجوم.

🚀 هل تريد تجربة آمنة لـ Agentic AI في مؤسستك؟

تواصل معنا / اطلب نسخة تجريبية الآن لنقدّم لك خطة تكامل أمني شاملة مخصصة لقطاعك.